O cérebro pode armazenar 10 vezes mais informação do que se pensava, segundo um novo estudo

Estudos recentes mostraram que o cérebro humano tem mais capacidade de armazenar informações do que se pensava anteriormente. Esta descoberta abre caminho para a compreensão dos processos no nosso cérebro e como estes funcionam em patologias como o Alzheimer.

Um grupo de investigadores desenvolveu um método para medir a força sináptica, a precisão da plasticidade e o armazenamento de informações no cérebro. Usando a teoria da informação, descobriram que as sinapses podem armazenar dez vezes mais informações do que se acreditava anteriormente, conforme indicado num relatório da NeuroScience News. Esta descoberta melhora a compreensão da aprendizagem, da memória e de como estes processos evoluem ou se deterioram ao longo do tempo.

Este conhecimento ajudará a impulsionar a investigação sobre doenças neurodegenerativas e do neurodesenvolvimento. Também poderá ajudar a compreender o processo por detrás dos distúrbios da memória e do cérebro, como o Alzheimer. O processo de aprender e lembrar de novas informações fortalece conexões importantes no nosso cérebro.

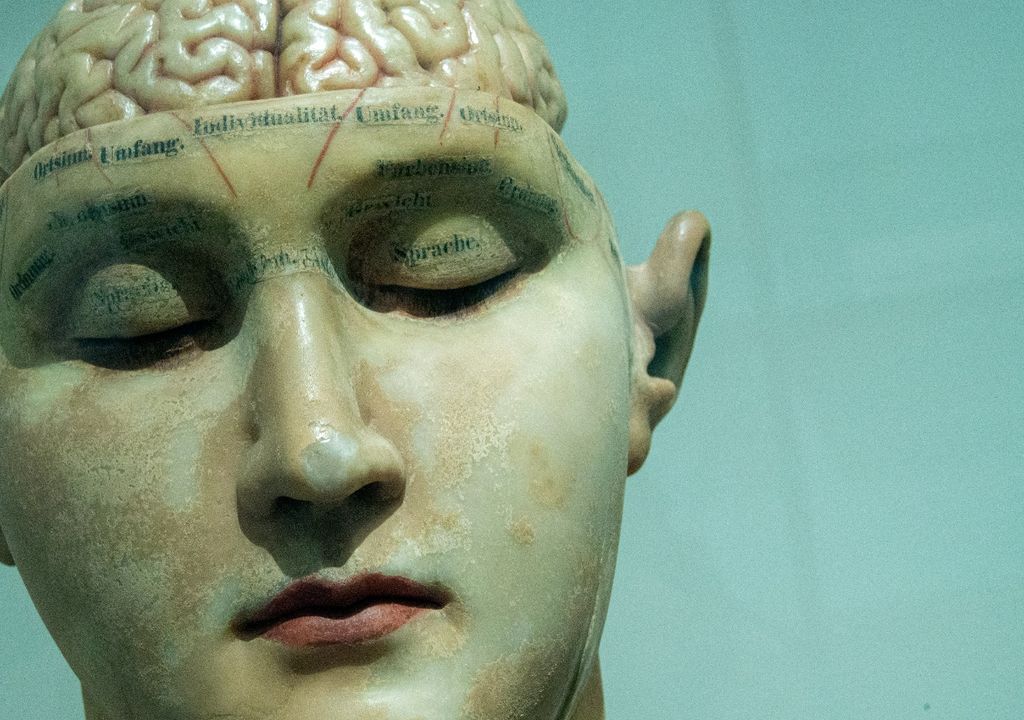

Por exemplo, quando repetimos alguma ação, seja num jogo ou num programa de computador, acabamos por ter mais facilidade nas vezes seguintes. Esta facilidade, que se deve à prática, é a prova de que estas conexões neurais, chamadas sinapses, podem fortalecer-se ou enfraquecer com o tempo, uma característica conhecida como plasticidade sináptica.

À procura de saber de que forma os humanos aprendem e se lembram

Ser capaz de quantificar a dinâmica das sinapses individuais pode ser um desafio para os neurocientistas, mas as recentes inovações computacionais no Instituto Salk podem estar a mudar isso e a revelar novos insights sobre o cérebro. Para compreender a forma como o cérebro aprende e retém informações, os cientistas tentam quantificar o quanto uma sinapse se tornou mais forte através da aprendizagem e o quão mais forte esta se pode tornar.

A força sináptica, segundo os cientistas, pode ser medida observando as características físicas das sinapses, mas é muito mais difícil medir a precisão da plasticidade. Isso é, se as sinapses enfraquecem ou fortalecem numa quantidade constante e que quantidade de informação uma sinapse pode armazenar. Por detrás disto está a busca pela compreensão de como os humanos aprendem e lembram, assim como estes processos evoluem ao longo do tempo ou se deterioram com a idade ou doenças.

Todas estas descobertas foram publicadas na Neural Computation do MIT em 23 de abril de 2024. A equipa foi liderada por Mohammad Samavat, da Universidade da Califórnia, San Diego. “Estamos a melhorar na identificação exata de onde e como os neurónios individuais estão conectados entre si, mas ainda temos muito que aprender sobre a dinâmica destas conexões”, disse o professor Terrence Sejnowski, outro dos principais autores do estudo.

É a porta que se abre para um maior conhecimento do cérebro

Terrence Sejnowski finalizou com uma declaração que apoia aqueles que pensam que o nosso cérebro é muito mais poderoso do que pensávamos. Ele disse que “criamos uma técnica para estudar a força das sinapses, a precisão com que os neurónios modulam essa força e a quantidade de informação que as sinapses são capazes de armazenar, o que nos levou a descobrir que o nosso cérebro pode armazenar dez vezes mais informações do que pensávamos anteriormente.”

Quando uma mensagem viaja pelo cérebro, salta de neurónio em neurónio, fluindo da extremidade de um neurónio para os tentáculos estendidos, chamados dendritos, de outro. Cada dendrito de um neurónio é coberto por pequenos apêndices bulbosos, chamados espinhas dendríticas, e no final de cada espinha dendrítica está a sinapse, um pequeno espaço onde as duas células se encontram e um sinal eletroquímico é transmitido. Diferentes sinapses são ativadas para enviar mensagens diferentes.

A teoria da informação é uma forma matemática sofisticada de compreender o processamento da informação como uma entrada que viaja através de um canal ruidoso e é reconstruída na outra extremidade. A equipe também mediu a quantidade de informações contidas no processo. Apesar das diferenças no tamanho de cada espinha dendrítica, cada uma das 24 categorias de força sináptica continha uma quantidade semelhante, variando entre 4,1 e 4,6 bits de informação.

Referência da notícia:

Samavat M., Bartol T., Harris K., et al. Synaptic Information Storage Capacity Measured With Information Theory. Neural Computation (2024).