Será a Inteligência Artificial o 'Grande Filtro' que faz com que as civilizações avançadas sejam raras no Universo?

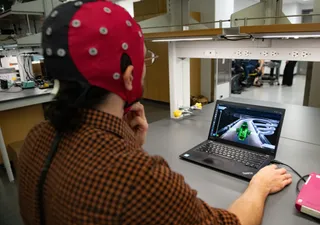

Atualmente, a Inteligência Artificial (IA) ajuda os cientistas a dar sentido a grandes quantidades de dados, ajuda a detetar fraudes financeiras, conduz os nossos carros, dá-nos sugestões de música, entre outras. E está apenas a começar. Saiba mais aqui!

O Paradoxo de Fermi é a discrepância entre a aparente elevada probabilidade de existirem civilizações avançadas no Universo e a total falta de provas de que elas existem. Muitas soluções têm sido propostas para explicar a razão desta discrepância. Uma destas é o "Grande Filtro".

O Grande Filtro é uma hipótese de acontecimento ou situação que impede a vida inteligente de se tornar interplanetária e interestelar e até leva ao seu desaparecimento. Pensemos em alterações climáticas, guerras nucleares, ataques de asteroides, explosões de supernovas, pragas ou qualquer outra coisa da galeria de eventos cataclísmicos.

Poderá o rápido desenvolvimento da IA ser um dos motivos do desaparecimento de civilizações avançadas?

Um novo artigo explora a ideia de que a Inteligência Artificial se transforma em Super Inteligência Artificial (ASI) e que a ASI é o Grande Filtro. O autor deste é Michael Garrett, do Departamento de Física e Astronomia da Universidade de Manchester.

Michael Garrett.

Há quem pense que o Grande Filtro impede que espécies tecnológicas como a nossa se tornem multiplanetárias. Isto é mau porque uma espécie corre um maior risco de extinção ou estagnação com apenas uma casa.

De acordo com Garrett, uma espécie está numa corrida contra o tempo sem um planeta de reserva. "Propõe-se que esse filtro surja antes de estas civilizações poderem desenvolver uma existência estável e multi-planetária, sugerindo que a longevidade típica de uma civilização é inferior a 200 anos", escreve Garrett.

A ser verdade, isto pode explicar a razão pela qual não detetamos tecnoassinaturas ou outras provas de ETIs (Inteligências Extraterrestres). O que é que isso nos diz sobre a nossa própria trajetória tecnológica? Se enfrentamos um constrangimento de 200 anos, e se isso se deve à ASI, onde é que isso nos deixa?

Garrett sublinha a "...necessidade crítica de estabelecer rapidamente quadros regulamentares para o desenvolvimento da IA na Terra e o avanço de uma sociedade multi-planetária para mitigar tais ameaças existenciais".

Muitos cientistas afirmam que estamos à beira de uma enorme transformação. A IA está apenas a começar a transformar a forma como fazemos as coisas; grande parte da transformação está nos bastidores. A IA parece estar preparada para eliminar o emprego de milhões de pessoas e, quando associada à robótica, a transformação parece quase ilimitada. Esta é uma preocupação bastante óbvia.

Garrett frisa que: "A preocupação com a possibilidade de a Superinteligência Artificial (ASI) acabar por se tornar desonesta é considerada uma questão importante - combater esta possibilidade nos próximos anos é um objetivo de investigação crescente para os líderes da área".

Poderá haver limite para a IA?

Se a IA não trouxesse benefícios, a questão seria muito mais fácil. Mas a IA proporciona todo o tipo de benefícios, desde melhores imagens e diagnósticos médicos a sistemas de transporte mais seguros. O truque para os governos é permitir que os benefícios floresçam, limitando os danos.

O problema é que nós e os nossos governos não estamos preparados. Nunca houve nada como a IA e, por mais que tentemos conceptualizá-la e compreender a sua trajetória, ficamos a desejar. E se estamos nesta posição, o mesmo acontece com qualquer outra espécie biológica que desenvolva a IA. O advento da IA e depois da ASI poderia ser universal, tornando-a candidata ao Grande Filtro.

Este é o risco que a ASI representa em termos concretos: pode deixar de precisar da vida biológica que a criou. "Ao atingir uma singularidade tecnológica, os sistemas ASI ultrapassarão rapidamente a inteligência biológica e evoluirão a um ritmo que ultrapassa completamente os mecanismos de controlo tradicionais, levando a consequências imprevistas e não intencionais que dificilmente estarão alinhadas com os interesses biológicos ou com a ética", explica Garrett.

Como poderia a ASI libertar-se da vida biológica incómoda que a encurrala? Poderia criar um vírus mortal, poderia inibir a produção e distribuição de alimentos agrícolas, poderia forçar o degelo de uma central nuclear e poderia iniciar guerras. Não sabemos realmente, pois é território desconhecido.

Por enquanto, a IA funciona dentro dos limites que nós estabelecemos. Mas pode nem sempre ser esse o caso. Não sabemos quando é que a IA se pode tornar ASI ou mesmo se pode. Mas não podemos ignorar essa possibilidade e é importante começarmos a implementar formas de controlar este tipo de inteligência.

Referência da notícia:

Garrett M. Is artificial intelligence the great filter that makes advanced technical civilisations rare in the universe?. Acta Astronautica (2024).