DeepSeek-R1: empresa chinesa lança modelo de IA que surpreendeu cientistas do mundo inteiro

A empresa chinesa DeepSeek lançou o seu modelo de raciocínio chamado DeepSeek-R1 que surpreendeu o mundo inteiro.

Nos últimos anos, quando se fala em inteligência artificial (IA) pensa-se logo no ChatGPT, que se destacou pela habilidade de compreender e gerar respostas. Apesar do ChatGPT ser o mais popular entre todos os chatbots com funções semelhantes, empresas como a Google, a Meta e o X lançaram as suas versões que competem com resultados cada vez melhores. Além de aplicações cada vez mais diversas.

Em 2024, a OpenAI resolveu avançar ainda mais com o anúncio dos modelos de raciocínio, chamados de o1 e o3. Estes modelos são treinados para lidar com problemas que exigem raciocínio como a resolução de problemas matemáticos e deduções em tempo real. Estes modelos de raciocínio utilizam diferentes técnicas que tentam imitar a forma como o cérebro humano raciocina.

Em pouco mais de 1 mês do anúncio do o3, a China entrou no jogo quando a empresa DeepSeek lançou o seu modelo DeepSeek-R1. O que chamou a atenção é que o modelo parece ter superado outros LLMs disponíveis de empresas grandes. Isto chamou a atenção de diversos especialistas em inteligência artificial que já comentaram sobre o assunto. O modelo chinês estabeleceu novos recordes de desempenho em benchmarks globais.

LLM

Os Large Language Models (LLMs), modelos treinados com uma grande quantidade de dados textuais que são de diferentes tipos. A maioria dos LLM são construídos com uso de Transformers e as suas camadas de atenção além da presença de redes neurais. Os Transformers foram introduzidos pela Google em 2017 e funcionam para capturar relações complexas entre palavras e contextos numa sequência.

Alguns LLMs disponíveis hoje são o GPT da OpenAI, o Gemini da Google, o Grok do X e o Llama do Meta. Estes modelos conseguem realizar tarefas como responder a perguntas, escrever textos criativos e alguns conseguem até gerar imagens. Apesar disso, estes modelos possuem limitações principalmente no quesito mais lógico e com isso, uma corrida para modelos melhores, como modelos de raciocínio, começou.

Modelos de raciocínio

Em 2024, a OpenAI surpreendeu ao anunciar os modelos de raciocínio chamados o1 e o3. Estes modelos são treinados de forma a incorporar lógica, dedução e capacidade analítica nas suas operações. São construídos para simular como é o processo de pensamento humano, como fazer inferência entre factos e informações e tomar decisões durante o processo de decisão.

Geralmente, os LLMs tradicionais respondem a perguntas utilizando a base de dados deles, já os modelos de raciocínio analisam diferentes fatores e informações desdobrando a pergunta em várias outras. Um exemplo é que um problema matemático pode ser dividido em várias partes onde abre cada etapa do processo.

DeepSeek-R1

A empresa DeepSeek é uma startup chinesa que foi fundada oficialmente em 2023 como uma empresa paralela da High-Flyer de 2015. Desde 2023, a DeepSeek lança modelos como o seu primeiro chamado DeepSeek Coder. Em janeiro desse ano, a empresa impressionou o mundo inteiro ao anunciar o DeepSeek-R1 que é um modelo de raciocínio que possui desempenho comparável e até melhor que os do o1 da OpenAI.

Mas o que chama a atenção no DeepSeek-R1 foi principalmente no uso de recursos que foram limitados em comparação aos outros sendo muito mais eficiente. Além disto, foi lançado como um modelo aberto para que investigadores do mundo inteiro possam estudá-lo e melhorá-lo. O modelo pode ser reutilizado e é muito mais barato do que os modelos dos concorrentes que tem custo e tamanho maiores.

Comparação com outros modelos

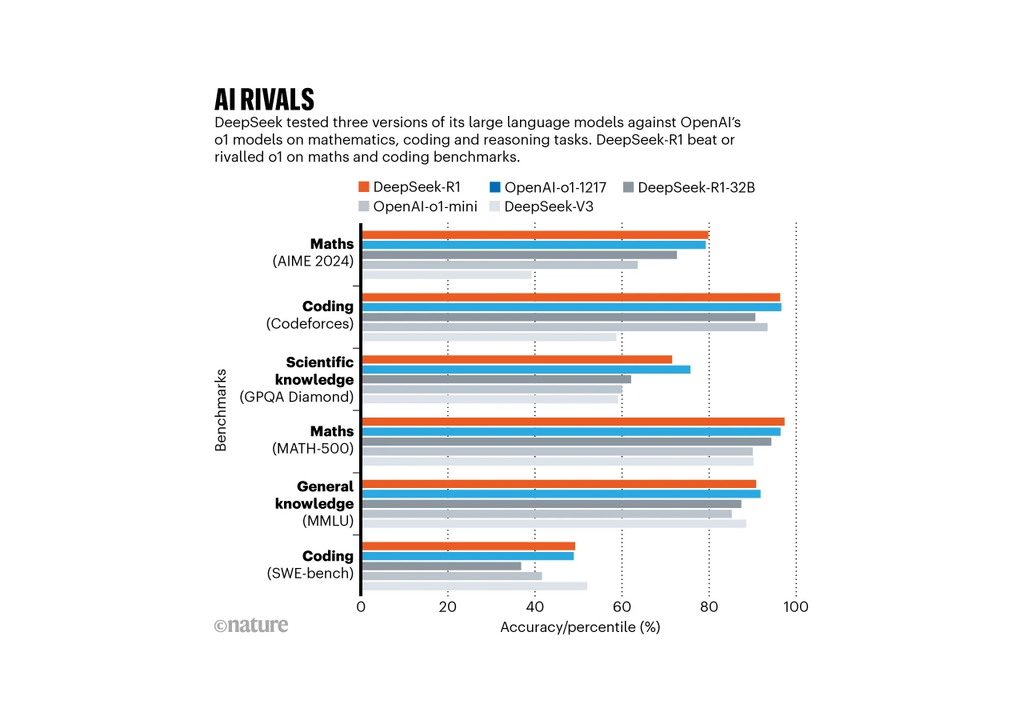

Para colocar o DeepSeek-R1 em jogo, a empresa fez alguns testes clássicos que foram detalhados num artigo publicado pela empresa. Nestes testes, o modelo chegou a 97,3% de acerto no conjunto MATH-500 de problemas matemáticos desenvolvidos por investigadores da Universidade da Califórnia. Além disso, o modelo conseguiu superar 96,3% dos participantes humanos na competição Codeforces.

Os resultados estão no mesmo nível das habilidades do modelo o1 da OpenAI e até consegue superar nalgumas tarefas. Ainda falta a comparação com o modelo o3 que foi lançado no final de 2024. Outros testes ainda estão a ser feitos, segundo a publicação da revista Nature, em cálculos específicos de óptica quântica, o DeepSeek-R1 superou o o1.

Referência da notícia

Gibney 2025 China’s cheap, open AI model DeepSeek thrills scientists Nature